Обзор Hi-End-видеокарты Point Of View GeForce GTX 280 1024 MB

Официальный анонс графического процессора NVIDIA GT200 состоялся 17 июня 2008 г. Компания представила на суд общественности видеокарту GeForce GTX 280, призванную стать флагманским решением нового поколения графических ускорителей именитой калифорнийской корпорации.

На этот раз NVIDIA постаралась кардинально, то есть не меняла какие-либо маркировки старых чипов и тем более не ускоряла старую карту на базе G92, присваивая ей новый индекс. GT200 — это совершенно новое кремниевое произведение калифорнийских инженеров, призванное отправить на покой нынешних флагманов высшего ценового диапазона 9800 GTX и 9800 GX2. Сегодня мы попытаемся выяснить, что же собой представляет очередное творение NVIDIA, каковы его недостатки и достоинства. Поскольку новоиспеченный GPU является новичком в стане наших лабораторных исследований, то сегодня теоретическая часть будет расширенной и весьма подробной.

Чип GT200: архитектурные возможности и особенности

Новоиспеченный чип используется пока в двух графических высокопроизводительных Hi-End-решениях: NVIDIA GeForce GTX 280 и NVIDIA GeForce GTX 260. Старшая плата (GTX 280) в стандартном исполнении несет на своем борту 1 Гб видеопамяти, а вторая являлась более урезанной версией того же GT200 — 896 Мб. Поскольку нынешние 3D-игры весьма требовательны к объему видеопамяти, то такие размеры фреймбуфера призваны увеличить производительность ускорителя в высоких разрешениях и особенно совместно с антиалиасингом. Кроме всего прочего, изменилась и шина доступа памяти — теперь это полноценный 512-битный интерфейс, набранный посредством восьми 64-битных блоков обмена с памятью. Напомним вам, что G80 довольствовался только 384-битной шиной, а G92 — и вовсе 256-битной. К сожалению, производитель не стал вводить поддержку DirectX 10.1 в GT200, мотивируя это тем, что в данной версии API имеются совсем незначительные отличия от DirectX 10. Позиция NVIDIA по этому поводу такова, что поддержка API DX10.1 не будет реализовываться в будущих поколениях GPU, а все силы будут сосредоточены уже на совместимости с API DirectX 11.

Новоиспеченный чип используется пока в двух графических высокопроизводительных Hi-End-решениях: NVIDIA GeForce GTX 280 и NVIDIA GeForce GTX 260. Старшая плата (GTX 280) в стандартном исполнении несет на своем борту 1 Гб видеопамяти, а вторая являлась более урезанной версией того же GT200 — 896 Мб. Поскольку нынешние 3D-игры весьма требовательны к объему видеопамяти, то такие размеры фреймбуфера призваны увеличить производительность ускорителя в высоких разрешениях и особенно совместно с антиалиасингом. Кроме всего прочего, изменилась и шина доступа памяти — теперь это полноценный 512-битный интерфейс, набранный посредством восьми 64-битных блоков обмена с памятью. Напомним вам, что G80 довольствовался только 384-битной шиной, а G92 — и вовсе 256-битной. К сожалению, производитель не стал вводить поддержку DirectX 10.1 в GT200, мотивируя это тем, что в данной версии API имеются совсем незначительные отличия от DirectX 10. Позиция NVIDIA по этому поводу такова, что поддержка API DX10.1 не будет реализовываться в будущих поколениях GPU, а все силы будут сосредоточены уже на совместимости с API DirectX 11.

Сердце видеоадаптера GeForce GTX 280 — это ядро под кодовым именем GT200, состоящее из 1,4 миллиарда (!!!) транзисторов (является самым емким и большим графическим процессором из когда-либо выпускаемых серийно). Площадь кристалла — 576 мм2, а его ширина достигает 2,4 см!

Сердце видеоадаптера GeForce GTX 280 — это ядро под кодовым именем GT200, состоящее из 1,4 миллиарда (!!!) транзисторов (является самым емким и большим графическим процессором из когда-либо выпускаемых серийно). Площадь кристалла — 576 мм2, а его ширина достигает 2,4 см!

Как факт здесь сразу же становится очевидным, что себестоимость такого графического решения очень высока, и с энергопотреблением GT200 не так все радужно — как заявляет производитель, "аппетит" GPU в режиме 3D достигает 236 Вт, а если представить связку из трех видеокарт Triple-SLI — тут и вовсе становится страшно. Инженерам NVIDIA на стадии проектирования GT200 пришлось решить целую массу задач, направленных на устранение недостатков и слабых мест прошлого чипа G92 и призванных в значительной степени увеличить эффективность и производительность архитектуры. Вычислительные блоки по своему функциональному назначению (со времен G80) остались без изменения, а вот сама компоновка ядра подверглась незначительной реорганизации.

GT200

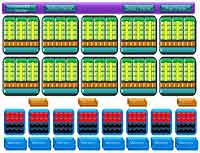

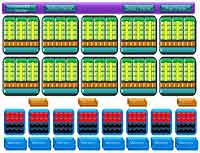

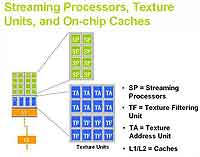

Ядро GT200 содержит в себе десять массивных текстурных кластеров TPC (Texture Processing Clusters), которые каждый состоят из трех

Ядро GT200 содержит в себе десять массивных текстурных кластеров TPC (Texture Processing Clusters), которые каждый состоят из трех

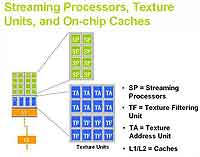

мультипроцессорных юнитов SM (streaming multiprocessors — SM). А SM, в свою очередь, представляют собой не что иное, как массив потоковых процессоров SP (по 8 шт. в каждом SM). В целом математика шейдерных блоков такова: 10 (TPC)*3(SM)*8 (SP) = 240 шт. Итак, давайте приглядимся поближе к одному такому суперскалярному кластеру (TPC), для сравнения также приведем аналогичную блок-схему чипа G92:

TPC графического процессора GT200

TPC графического процессора GT200

Как видно из диаграммы, каждый блок TPS имеет локальную память объемом 16 Kb, разделяющую собой массивы потоковых процессоров в каждом мультипроцессорном юните. В остальном же (за исключением количественной составляющей) визуально ничего не изменилось. Куда больше усовершенствований содержится в возможностях текстурных кластеров GT200 по сравнению с G92. Это выполнение двух инструкций за такт в одном шейдере, увеличенный файл локального регистрового файла в каждом блоке SM (призвана значительно улучшить производительность чипа при выполнении сложных и длинных шейдеров) и, наконец, увеличенная точность вычислений с плавающей запятой. Текстурные блоки (TMU) графического чипа нового поколения остались без каких-либо весомых изменений.

TPC графического процессора G92

TPC графического процессора G92

Разве только (по заявлению самой NVIDIA) эффективность текстурирования благодаря новой логике управления ресурсами увеличилась примерно на 22% по сравнению с чипами прошлого поколения — в частности, G92. Напоследок не забудем отметить блоки ROP графического процессора GT200. Их эффективность, в отличие от TMU, была серьезно переработана, в результате чего блоки записи в буфер кадра теперь легко выводят до 32 пикселей за такт совместно с блендингом, в то время как G80 мог реализовать только 12 пикселей за такт с блендингом. На этом с функциональными блоками мы, пожалуй, закончим и приступим к изучению основных технологических возможностей GPU GT200.

NVIDIA CUDA

В данный момент NVIDIA занимается активным продвижением своей технологии CUDA. Она позволяет задействовать вычислительные ресурсы чипа для решения сложных задач моделирования математических расчетов и других вычислительных задач. Операции с плавающей запятой выполняются в формате IEEE 754R (с повышенной точностью — специальный стандарт, разработанный институтом инженеров по электротехнике и электронике в 1985 году). Благодаря технологии CUDA GT200 может эффективно справляться с широким спектром задач. Это молекулярная физика, кодирование видеоданных, обработка изображений, моделирование физических явлений и прочих не менее важных научных и инженерных задач. Благодаря CUDA и большому количеству потоковых процессоров GT200 обыкновенный ПК легко превращается в небольшой суперкомпьютер, как заявляет производитель, суммарной вычислительной мощностью в 1 терафлоп. Один из наиболее популярных проектов, работающих с NVIDIA CUDA, — это известная сеть распределенных вычислений Folding@home.

NVIDIA PhysX

Уже было давно выяснено, что расчет физических процессов (попросту физики) в играх наиболее эффективно реализовывать не средствами CPU, а средствами графического процессора. Первой технологией, утилизирующей возможности GPU "на благо физических эффектов в 3D-приложениях", стала PhysX компании Ageia. Вскоре Ageia была куплена NVIDIA, а возможности движка PhysX шустро перекочевали к ускорителям калифорнийского брэнда. Как показали многочисленные тесты, преимущество графического чипа в этих видах операций налицо. Движок PhysX может эффективно реализовывать множество видов эффектов, из которых особенно выделяются:

. физика жидкостей и газов;

. физика тканей;

. динамические эффекты частиц (дым, пыль);

. моделирование погодных явлений.

HybridPower и режимы управления питанием

Технология утилизирует возможности встроенного в материнскую плату видеоядра для визуализации 2D-картинки и просмотра видео с аппаратным ускорением, при этом внешние платы переводятся в режим сна или вовсе отключаются. Такие нехитрые манипуляции позволят значительно снизить энергопотребление всей системы в целом, также снизить нагрев и — как следствие — шум установленной видеокарты. Далее при активизации мощного 3D- приложения автоматически активизируются ресурсы уже внешней видеокарты, которая и будет отвечать за результирующий показатель FPS и прорисовку картинки. Не стоит также забывать о том, что HybridPower должна поддерживать не только ваша видеокарта, но и материнская плата. В списках на момент написания материала значатся следующие наборы логики, работающие с HybridPower:

. GeForce 8300;

. GeForce 8200;

. GeForce 8100;

. nForce 780a SLI;

. nForce 750a SLI;

. nForce 730a;

. nForce 720a.

Кроме того, видеочип научился динамически изменять частоты и напряжение функциональных блоков ядра в зависимости от текущих задач и их нагрузки. Это позволяет избежать значительного перерасхода энергии в режиме простоя видеокарты. Нечто подобное AMD/ATI уже давно применяла в своих графических платах, а теперь "прогресс" добрался и до плат NVIDIA.

NVIDIA SLI и 3-Way SLI

GeForce GTX 280 поддерживает обновленную версию технологии SLI, которая теперь позволит легко обеспечить согласованную работу до трех таких графических ускорителей. Для реализации 3-Way SLI обязательно наличие поддержки технологии со стороны системной платы. На данный момент официально поддерживается платами на основе чипсетов NVIDIA nForce 680i, 780i, 780a, 790i. Как сообщает разработчик, производительность системы на основе трех GeForce GTX 280 должна обеспечить прирост производительности в районе 130-170%. Конечно, все исследования проводились в режимах с максимальными графическими настройками и высокими разрешениями. При меньших нагрузках использование массива из трех видеокарт становится практически нецелесообразным.

PureVideo и PureVideo HD

Ядро GT200, как и G92/94, имеет поддержку уже давно всем знакомой технологии PureVideo (для улучшенной обработки видео), а также PureVideo HD. Последняя поддерживает форматы HD DVD и Blu-ray и предназначена освободить центральный процессор от тяжкого бремени декодирования

видеоинформации посредством встроенного декодера форматов H.264, VC-1, WMV/WMV-HD и MPEG-2 HD. Помимо этого, с помощью технологии PureVideo HD возможно реализовать следующие виды постобработки:

. корректировку цвета;

. сглаживание картинки;

. устранение шума.

Напоследок отметим все основные технические характеристики чипа GT200 и видеокарт на его основе:

. кодовое название чипа — GT200;

. технологический процесс изготовления — 65 нм;

. количество транзисторов — 1,4 млрд;

. частота работы ядра — 600 МГц (GTX 280);

. 240 унифицированных скалярных процессоров, работающих на частоте 1300 МГц;

. 80 текстурных блоков с поддержкой операций с плавающей запятой FP16 и FP32;

. 8 блоков записи в кадровый буфер (ROP), (32 накладываемые текстуры за проход);

. ширина шины памяти — 512 бит;

. объем видеопамяти — 1024 Мб типа GDDR3 с частотой 1800 МГц DDR (GTX 280);

. полоса пропускания памяти — 141,7 Гб/с (GTX 280);

. аппаратная поддержка АРI Direct X 10, Shader Model 4.0, а также OpenGL 2.1;

. возможность организации массива из двух/трех видеокарт NVIDIA SLI;

. аппаратное декодирование видео — PureVideo;

. аппаратное декодирование видео высокой четкости — PureVideo HD;

. интерфейсы — 2x DVI Dual Link, HDMI, HDTV;

. 2x RAMDAC 400 МГц;

. интегрированная в ядро поддержка TV-выхода.

*На момент подготовки материала.

Итак, в верхнем ценовом диапазоне компании NVIDIA разместились четыре видеокарты со следующими рекомендованными стоимостями:

. NVIDIA GeForce GTX 280 — $499;

. NVIDIA GeForce GTX 280 — $299.

"Хм… что-то уж больно дешево для флагманской платы!"- подумаете вы, и будете правы. Изначально стоимость ускорителя GTX 280 составляла $649 (!), в то время как цена на GTX 260 должна была быть около $399. Но тут в дело вмешалась AMD, которая представила весьма конкурентоспособные и высокопроизводительные чипы линейки HD 48ХХ, на что NVIDIA, кроме как снижением цен, собственно говоря, ответить было нечем. Такое положение дел очень отрицательно отразилось на материальном положении калифорнийского брэнда, ведь "супертранзисторный" GT200 обходится компании довольно дорого, а тут еще и снижение цен… С другой стороны, такие обстоятельства весьма обрадуют покупателей, так как не лишним будет сэкономить $100- $150, а это более чем приятно! На этом с теорией, пожалуй, закончим — настало время перейти к практическим тестам, правда, перед этим нужно поближе познакомиться с сегодняшним гостем, чем мы, собственно говоря, сейчас и займемся.

Видеокарта Point Of View GeForce GTX 280 1024 MB

Комплектация, дизайн PCB и конструкция системы охлаждения

Видеокарта поставляется в боксе средних размеров с удобной пластмассовой ручкой для переноски.

Видеокарта поставляется в боксе средних размеров с удобной пластмассовой ручкой для переноски.

В целом по факту размещения характеристик и особенностей продукта на коробке нареканий нет, а вот дизайн оформления бокса — на любителя. Внутри коробки по отсекам уложен следующий комплект:

. руководство по быстрой установке;

. CD с драйверами и утилитами;

. переходник DVI-I на D-SUB;

. переходник DVI-I на HDMI;

. специальный переходник питания 2х Molex на 6-пиновый PCI Express;

. специальный переходник питания 2х 6-пиновый PCI Express -> 8-пиновый PCI Express;

. аудиокабель для передачи звука на разъем HDMI.

Комплект поставки POV GeForce GTX 280 обладает излишней скромностью. Бонусы отсутствуют, кабели и переходники S-Video тоже. Как показала практика, производители видеокарт на базе референсных решений стремятся как-то выделиться из серой массы аналогичных предложений на рынке всевозможными бонусными программами, ведь характеристики таких плат будут идентичны, а выбор пользователей будет в основном обусловлен наличием "нужного" комплекта к видеокарте. Не знаем, на что рассчитывают ребята из Point Of View, но для видеокарт высшего ценового диапазона урезать комплект — значит, поступить опрометчиво.

Комплект поставки POV GeForce GTX 280 обладает излишней скромностью. Бонусы отсутствуют, кабели и переходники S-Video тоже. Как показала практика, производители видеокарт на базе референсных решений стремятся как-то выделиться из серой массы аналогичных предложений на рынке всевозможными бонусными программами, ведь характеристики таких плат будут идентичны, а выбор пользователей будет в основном обусловлен наличием "нужного" комплекта к видеокарте. Не знаем, на что рассчитывают ребята из Point Of View, но для видеокарт высшего ценового диапазона урезать комплект — значит, поступить опрометчиво.

В плане дизайна PCB данная плата полностью идентична классической GeForce GTX 280.

Длина видеокарты GeForce GTX 280 составляет 270 мм, что полностью соответствует типичной NVIDIA GeForce 8800 GTX. Высота всей конструкции неизменна по всей длине и составляет 30 мм, поэтому на материнской плате ниже разъема PCE-16x не должно быть сильно выступающих элементов и разъемов, иначе карта просто физически не "встанет". Для дополнительной подпитки видеокарты используется один 6-контактный разъем и один 8- контактный.

Плата не будет работать от двух 6-пиновых разъемов — для нее обязательно включение 8-пинового "хвоста". Помимо прочего, данные платы также оснащаются специальным разъемом, предназначенным для передачи звука от аудиокарты посредством специального кабеля на разъем HDMI. На задней коммутационной панели видеокарты распаяны следующие разъемы: 2х DVI (Dual-Link) и TV-выход. PCB платы значительно усложнилась в сравнении с прошлыми поколениями видеокарт, что и неудивительно, ведь теперь инженерам пришлось постараться, чтобы "упаковать" 1 гигабайт видеопамяти и 512-битный интерфейс в размеры стандартной 8800 GTX (270 мм). Кроме того, мы видим хорошо знакомую микросхему NVIO, которая содержит блоки, отвечающие за вывод информации, которые, образно говоря, не поместились в GT200. GPU в нашем случае ревизии A1 и выпущен на 25-й неделе 2008 года на Тайване. Он работает на частотах, соответствующих эталонной GTX 280 — 600 МГц. Видеопамять типа GDDR3 SDRAM общим объемом 1024 Мб расположена на лицевой и тыльной сторонах видеокарты и набрана с помощью 16 микросхем по 64 Мб каждая. Производитель чипов — компания Samsung. Время выборки у всех микросхем составляет 1,0 нс, что соответствует частоте 1000 (2000) МГц. Далее рассмотрим систему охлаждения GPU.

Плата не будет работать от двух 6-пиновых разъемов — для нее обязательно включение 8-пинового "хвоста". Помимо прочего, данные платы также оснащаются специальным разъемом, предназначенным для передачи звука от аудиокарты посредством специального кабеля на разъем HDMI. На задней коммутационной панели видеокарты распаяны следующие разъемы: 2х DVI (Dual-Link) и TV-выход. PCB платы значительно усложнилась в сравнении с прошлыми поколениями видеокарт, что и неудивительно, ведь теперь инженерам пришлось постараться, чтобы "упаковать" 1 гигабайт видеопамяти и 512-битный интерфейс в размеры стандартной 8800 GTX (270 мм). Кроме того, мы видим хорошо знакомую микросхему NVIO, которая содержит блоки, отвечающие за вывод информации, которые, образно говоря, не поместились в GT200. GPU в нашем случае ревизии A1 и выпущен на 25-й неделе 2008 года на Тайване. Он работает на частотах, соответствующих эталонной GTX 280 — 600 МГц. Видеопамять типа GDDR3 SDRAM общим объемом 1024 Мб расположена на лицевой и тыльной сторонах видеокарты и набрана с помощью 16 микросхем по 64 Мб каждая. Производитель чипов — компания Samsung. Время выборки у всех микросхем составляет 1,0 нс, что соответствует частоте 1000 (2000) МГц. Далее рассмотрим систему охлаждения GPU.

Вся конструкция состоит из двух половинок: лицевого радиатора с кулером (охлаждает ядро и память) и алюминиевой пластины, охлаждающей чипы памяти на обратной стороне. Радиаторы стягиваются между собой винтами и закрепляются друг с другом защелками. К слову сказать, именно на этапе разъема двух половинок кулера и возникают проблемы — слишком уж плотно они сидят, в результате чего плату можно запросто повредить излишним усилием. По принципу работы системы охлаждения рассматриваемый экземпляр ничем не отличается от аналогичных "двухэтажных" плат NVIDIA — воздух продувается турбиной через ребра системы охлаждения, накрытые пластиковым кожухом. Алюминиевый каркас теплораспределителя имеет многочисленные выступы, которые контактируют с памятью, элементами питания и чипом NVIO, при этом используется термоинтерфейс в виде пропитанной специальным веществом прокладки.

Вся конструкция состоит из двух половинок: лицевого радиатора с кулером (охлаждает ядро и память) и алюминиевой пластины, охлаждающей чипы памяти на обратной стороне. Радиаторы стягиваются между собой винтами и закрепляются друг с другом защелками. К слову сказать, именно на этапе разъема двух половинок кулера и возникают проблемы — слишком уж плотно они сидят, в результате чего плату можно запросто повредить излишним усилием. По принципу работы системы охлаждения рассматриваемый экземпляр ничем не отличается от аналогичных "двухэтажных" плат NVIDIA — воздух продувается турбиной через ребра системы охлаждения, накрытые пластиковым кожухом. Алюминиевый каркас теплораспределителя имеет многочисленные выступы, которые контактируют с памятью, элементами питания и чипом NVIO, при этом используется термоинтерфейс в виде пропитанной специальным веществом прокладки.

Температурный режим, разгон, уровень энергопотребления исследуемых плат

Для мониторинга тепловых показателей ускорителя воспользуемся утилитой RivaTuner 2.11. Для большей наглядности все данные сведем в

соответствующую таблицу:

*Измерено с помощью цифрового термометра Mastech MS-6501.

При работе в 2D-режиме, когда утилизация графического процессора мала, вентилятор вращается на весьма низких оборотах, при этом оставаясь бесшумным. Обратите внимание на снижение частоты памяти GPU — до 100 МГц и 300 МГц соответственно (!), что позволяет в действительности значительно сократить энергопотребление видеокарты при работе с 2D-картинкой. В режимах высокой степени загрузки GPU видеокарты (3D-игры) кулер раскручивался до 2300 об/мин, при этом шум его работы можно охарактеризовать как умеренный. Температура графического ядра при этом

При работе в 2D-режиме, когда утилизация графического процессора мала, вентилятор вращается на весьма низких оборотах, при этом оставаясь бесшумным. Обратите внимание на снижение частоты памяти GPU — до 100 МГц и 300 МГц соответственно (!), что позволяет в действительности значительно сократить энергопотребление видеокарты при работе с 2D-картинкой. В режимах высокой степени загрузки GPU видеокарты (3D-игры) кулер раскручивался до 2300 об/мин, при этом шум его работы можно охарактеризовать как умеренный. Температура графического ядра при этом

поддерживалась на уровне 85°С, что не выходит за рамки допустимого.

Разгонные показатели Point Of View GeForce GTX 280 1024 MB:

*Измерено с помощью цифрового градусника Mastech MS-6501.

** При частотах кулера 70% (принудительно установленные посредством утилиты RivaTuner).

Чем сложнее чип, чем больше транзисторов, тем труднее он поддается разгону и всевозможным манипуляциям с его частотами. Совершенно очевидно, что большого прироста (до 25%, как у G92) в плане разгона от GT200 ожидать и не приходится.

Конфигурация тестового стенда, список тестовых приложений и настроек

Конфигурация тестового стенда:

В тестировании, помимо Point Of View GeForce GTX 280 1024 MB, также принимали участие:

. NVIDIA GeForce GTX 260;

. NVIDIA GeForce 9800 GTX;

. NVIDIA GeForce 9800 GX2;

. AMD Radeon HD 4870.

Во время тестирования использовались следующие настройки драйверов:

Для GeForce 178.13:

. texture filtering — high quality;

. vertical sync — off;

. anisotropic optimization — off;

. anisotropic sample optimization — off;

. transparency antialiasing — off.

Для AMD Catalyst 8.9:

. Catalyst A.I — standard;

. mipmap detail level — high quality;

. wait for vertical refresh — off;

. adaptive antialiasing — off;

. temporal antialiasing — off;

. high quality anisotropic filtering — off.

Все остальные настройки — по умолчанию.

Анализ производительности проводился в трех стандартных для нашей методики разрешениях: 1024x768, 1280х1024 и 1920х1080 пикселей. Измерение производительности осуществлялось встроенными в игру бенчмарками, а при их отсутствии — утилитой FRAPS на специально подобранных, простых для повторения сценах. Прогон тестов (для замеров при помощи FRAPS) осуществлялся минимум три раза, чтобы исключить случайные погрешности экспериментов. В качестве тестовых приложений использовались следующие приложения и настройки:

Анализ производительности проводился в трех стандартных для нашей методики разрешениях: 1024x768, 1280х1024 и 1920х1080 пикселей. Измерение производительности осуществлялось встроенными в игру бенчмарками, а при их отсутствии — утилитой FRAPS на специально подобранных, простых для повторения сценах. Прогон тестов (для замеров при помощи FRAPS) осуществлялся минимум три раза, чтобы исключить случайные погрешности экспериментов. В качестве тестовых приложений использовались следующие приложения и настройки:

Выводы

Несомненно, на данный момент GT200 является самым сложным и высокопроизводительным чипом на рынке. К сожалению, в архитектурном плане новоиспеченный чип не представляет ничего кардинально нового. В некоторых моментах NVIDIA действительно удалось значительно повысить эффективность архитектуры, а также существенно увеличить количество вычислительных блоков по отношению к прошлым чипам, в остальном же GT200 мало чем отличается от G92. Производительность GeForce GTX 280 ощутимо шагнула вперед по сравнению с одиночным G92 (GeForce 9800 GTX), но не стоит забывать, что на рынке присутствует также мощное мультичиповое решение GeForce 9800 GX2, которое по результатам наших тестов в основной массе бенчмарков обходит GTX 280. Правда, в этом случае стоит обязательно учитывать тот факт, что вычислительная мощь мультичиповых плат во многом зависит от драйверов и соответствующей оптимизации приложений под многоядерный рендеринг. Поэтому multi-GPU-видеокарта может показывать превосходную производительность только в популярных бенчмарках и играх, а в менее ходовых могут наблюдаться проблемы. Основная "болезнь" нынешнего флагманского чипа GT200 кроется в его высоком энергопотреблении и тепловыделении. Решить эту проблему (как один из вариантов) кардинальным образом можно лишь перейдя на более тонкий техпроцесс. Кроме того, это позволит значительно снизить себестоимость производства таких чипов.

Point Of View GeForce GTX 280 1024 MB

Дизайн платы полностью соответствует референсному GeForce GTX 280, посему выбор в пользу того или иного брэнда (из многообразия стандартных плат) практически полностью будет зависеть от бонусов, комплекта и цены.

Плюсы:

. высокая производительность в приложениях (для одиночного чипа);

. приемлемая эффективность и шум системы охлаждения (с учетом очень горячего нрава GT200).

Минусы:

. скудный комплект поставки;

. низкий разгонный потенциал.

Дмитрий Трамбицкий

На этот раз NVIDIA постаралась кардинально, то есть не меняла какие-либо маркировки старых чипов и тем более не ускоряла старую карту на базе G92, присваивая ей новый индекс. GT200 — это совершенно новое кремниевое произведение калифорнийских инженеров, призванное отправить на покой нынешних флагманов высшего ценового диапазона 9800 GTX и 9800 GX2. Сегодня мы попытаемся выяснить, что же собой представляет очередное творение NVIDIA, каковы его недостатки и достоинства. Поскольку новоиспеченный GPU является новичком в стане наших лабораторных исследований, то сегодня теоретическая часть будет расширенной и весьма подробной.

Чип GT200: архитектурные возможности и особенности

Как факт здесь сразу же становится очевидным, что себестоимость такого графического решения очень высока, и с энергопотреблением GT200 не так все радужно — как заявляет производитель, "аппетит" GPU в режиме 3D достигает 236 Вт, а если представить связку из трех видеокарт Triple-SLI — тут и вовсе становится страшно. Инженерам NVIDIA на стадии проектирования GT200 пришлось решить целую массу задач, направленных на устранение недостатков и слабых мест прошлого чипа G92 и призванных в значительной степени увеличить эффективность и производительность архитектуры. Вычислительные блоки по своему функциональному назначению (со времен G80) остались без изменения, а вот сама компоновка ядра подверглась незначительной реорганизации.

GT200

мультипроцессорных юнитов SM (streaming multiprocessors — SM). А SM, в свою очередь, представляют собой не что иное, как массив потоковых процессоров SP (по 8 шт. в каждом SM). В целом математика шейдерных блоков такова: 10 (TPC)*3(SM)*8 (SP) = 240 шт. Итак, давайте приглядимся поближе к одному такому суперскалярному кластеру (TPC), для сравнения также приведем аналогичную блок-схему чипа G92:

Как видно из диаграммы, каждый блок TPS имеет локальную память объемом 16 Kb, разделяющую собой массивы потоковых процессоров в каждом мультипроцессорном юните. В остальном же (за исключением количественной составляющей) визуально ничего не изменилось. Куда больше усовершенствований содержится в возможностях текстурных кластеров GT200 по сравнению с G92. Это выполнение двух инструкций за такт в одном шейдере, увеличенный файл локального регистрового файла в каждом блоке SM (призвана значительно улучшить производительность чипа при выполнении сложных и длинных шейдеров) и, наконец, увеличенная точность вычислений с плавающей запятой. Текстурные блоки (TMU) графического чипа нового поколения остались без каких-либо весомых изменений.

Разве только (по заявлению самой NVIDIA) эффективность текстурирования благодаря новой логике управления ресурсами увеличилась примерно на 22% по сравнению с чипами прошлого поколения — в частности, G92. Напоследок не забудем отметить блоки ROP графического процессора GT200. Их эффективность, в отличие от TMU, была серьезно переработана, в результате чего блоки записи в буфер кадра теперь легко выводят до 32 пикселей за такт совместно с блендингом, в то время как G80 мог реализовать только 12 пикселей за такт с блендингом. На этом с функциональными блоками мы, пожалуй, закончим и приступим к изучению основных технологических возможностей GPU GT200.

NVIDIA CUDA

В данный момент NVIDIA занимается активным продвижением своей технологии CUDA. Она позволяет задействовать вычислительные ресурсы чипа для решения сложных задач моделирования математических расчетов и других вычислительных задач. Операции с плавающей запятой выполняются в формате IEEE 754R (с повышенной точностью — специальный стандарт, разработанный институтом инженеров по электротехнике и электронике в 1985 году). Благодаря технологии CUDA GT200 может эффективно справляться с широким спектром задач. Это молекулярная физика, кодирование видеоданных, обработка изображений, моделирование физических явлений и прочих не менее важных научных и инженерных задач. Благодаря CUDA и большому количеству потоковых процессоров GT200 обыкновенный ПК легко превращается в небольшой суперкомпьютер, как заявляет производитель, суммарной вычислительной мощностью в 1 терафлоп. Один из наиболее популярных проектов, работающих с NVIDIA CUDA, — это известная сеть распределенных вычислений Folding@home.

NVIDIA PhysX

Уже было давно выяснено, что расчет физических процессов (попросту физики) в играх наиболее эффективно реализовывать не средствами CPU, а средствами графического процессора. Первой технологией, утилизирующей возможности GPU "на благо физических эффектов в 3D-приложениях", стала PhysX компании Ageia. Вскоре Ageia была куплена NVIDIA, а возможности движка PhysX шустро перекочевали к ускорителям калифорнийского брэнда. Как показали многочисленные тесты, преимущество графического чипа в этих видах операций налицо. Движок PhysX может эффективно реализовывать множество видов эффектов, из которых особенно выделяются:

. физика жидкостей и газов;

. физика тканей;

. динамические эффекты частиц (дым, пыль);

. моделирование погодных явлений.

HybridPower и режимы управления питанием

Технология утилизирует возможности встроенного в материнскую плату видеоядра для визуализации 2D-картинки и просмотра видео с аппаратным ускорением, при этом внешние платы переводятся в режим сна или вовсе отключаются. Такие нехитрые манипуляции позволят значительно снизить энергопотребление всей системы в целом, также снизить нагрев и — как следствие — шум установленной видеокарты. Далее при активизации мощного 3D- приложения автоматически активизируются ресурсы уже внешней видеокарты, которая и будет отвечать за результирующий показатель FPS и прорисовку картинки. Не стоит также забывать о том, что HybridPower должна поддерживать не только ваша видеокарта, но и материнская плата. В списках на момент написания материала значатся следующие наборы логики, работающие с HybridPower:

. GeForce 8300;

. GeForce 8200;

. GeForce 8100;

. nForce 780a SLI;

. nForce 750a SLI;

. nForce 730a;

. nForce 720a.

Кроме того, видеочип научился динамически изменять частоты и напряжение функциональных блоков ядра в зависимости от текущих задач и их нагрузки. Это позволяет избежать значительного перерасхода энергии в режиме простоя видеокарты. Нечто подобное AMD/ATI уже давно применяла в своих графических платах, а теперь "прогресс" добрался и до плат NVIDIA.

NVIDIA SLI и 3-Way SLI

GeForce GTX 280 поддерживает обновленную версию технологии SLI, которая теперь позволит легко обеспечить согласованную работу до трех таких графических ускорителей. Для реализации 3-Way SLI обязательно наличие поддержки технологии со стороны системной платы. На данный момент официально поддерживается платами на основе чипсетов NVIDIA nForce 680i, 780i, 780a, 790i. Как сообщает разработчик, производительность системы на основе трех GeForce GTX 280 должна обеспечить прирост производительности в районе 130-170%. Конечно, все исследования проводились в режимах с максимальными графическими настройками и высокими разрешениями. При меньших нагрузках использование массива из трех видеокарт становится практически нецелесообразным.

PureVideo и PureVideo HD

Ядро GT200, как и G92/94, имеет поддержку уже давно всем знакомой технологии PureVideo (для улучшенной обработки видео), а также PureVideo HD. Последняя поддерживает форматы HD DVD и Blu-ray и предназначена освободить центральный процессор от тяжкого бремени декодирования

видеоинформации посредством встроенного декодера форматов H.264, VC-1, WMV/WMV-HD и MPEG-2 HD. Помимо этого, с помощью технологии PureVideo HD возможно реализовать следующие виды постобработки:

. корректировку цвета;

. сглаживание картинки;

. устранение шума.

Напоследок отметим все основные технические характеристики чипа GT200 и видеокарт на его основе:

. кодовое название чипа — GT200;

. технологический процесс изготовления — 65 нм;

. количество транзисторов — 1,4 млрд;

. частота работы ядра — 600 МГц (GTX 280);

. 240 унифицированных скалярных процессоров, работающих на частоте 1300 МГц;

. 80 текстурных блоков с поддержкой операций с плавающей запятой FP16 и FP32;

. 8 блоков записи в кадровый буфер (ROP), (32 накладываемые текстуры за проход);

. ширина шины памяти — 512 бит;

. объем видеопамяти — 1024 Мб типа GDDR3 с частотой 1800 МГц DDR (GTX 280);

. полоса пропускания памяти — 141,7 Гб/с (GTX 280);

. аппаратная поддержка АРI Direct X 10, Shader Model 4.0, а также OpenGL 2.1;

. возможность организации массива из двух/трех видеокарт NVIDIA SLI;

. аппаратное декодирование видео — PureVideo;

. аппаратное декодирование видео высокой четкости — PureVideo HD;

. интерфейсы — 2x DVI Dual Link, HDMI, HDTV;

. 2x RAMDAC 400 МГц;

. интегрированная в ядро поддержка TV-выхода.

| Видеокарта | NVIDIA GeForce 9800 GTX | NVIDIA GeForce 9800 GX2 | NVIDIA GeForce GTX 280 | NVIDIA GeForce GTX 260 | AMD Radeon HD 4870 X2 | AMD Radeon HD 3870 X2 | AMD Radeon HD 4870 |

| Кодовое название чипа | G92 | 2хG92 | GT200 | GT200 | 2хRV770 | R680 | RV770 |

| Техпроцесс | 65 нм | 65 нм | 65 нм | 65 нм | 55 нм | 55 нм | 55 нм |

| Количество транзисторов | 754 млн | 2х754 млн | 1,4 млрд | 1,4 млрд | 2х956 млн | 2х666 млн | 956 млн |

| Тактовые частоты чипа, МГц | 675 | 600 | 600 | 576 | 2х750 | 825 | 750 |

| Тактовые частоты шейдерного домена, МГц | 1688 | 1500 | 1300 | 1240 | 2х750 | 825 | 750 |

| Эффективная частота памяти, МГц | 2200 | 2000 | 2200 | 2000 | 2х3600 | 1800 | 3600 |

| Максимальная пропускная способность памяти, Гб/с | 70,4 | 2х64 | 141,7 | 111,9 | 2х115 | 2x57,6 | 115 |

| Объем и тип используемой памяти | 512 Мб GDDR3 | 2х512 Мб GDDR3 | 1024 Мб GDDR3 | 896 Мб GDDR3 | 2х1024 Мб GDDR5 | 2х512 Мб GDDR4 | 512 Мб/1 Гб GDDR5 |

| Количество универсальных процессоров | 128 | 2х128 | 240 | 192 | 2х800 | 2х320 | 800 |

| TMU (текстурные блоки) | 64 | 2х64 | 80 | 64 | 2х40 | 2х16 | 40 |

| ROP (пикс/такт) | 16 | 2х16 | 32 | 28 | 2х16 | 2х16 | 16 |

| Филлрейт, теоретический (Мпкс) | 10800 | 2х9600 | 19300 | 16100 | 2х12000 | 2х13200 | 12000 |

| Тексельрейт, теоретический (Мткс) | 43200 | 2х38000 | 48200 | 36900 | 2х30000 | 2х13200 | 30000 |

| Полноэкранное сглаживание | MSAA 2х, 4х, 8х CSAA 2x-16x | MSAA 2х, 4х, 8х CSAA 2x-16x | MSAA 2х, 4х, 8х CSAA 2x-16x | MSAA 2х, 4х, 8х CSAA 2x-16x | MSAA 2х, 4х, 8х и CFAA до 24x | MSAA 2х, 4х, 8х и CFAA до 24x | MSAA 2х, 4х, 8х и CFAA до 24x |

| Анизотропная фильтрация (AF) | 2х, 4х, 8х, 16х | 2х, 4х, 8х, 16х | 2х, 4х, 8х, 16х | 2х, 4х, 8х, 16х | 2х, 4х, 8х, 16х | 2х, 4х, 8х, 16х | 2х, 4х, 8х, 16х |

| Ширина шины памяти, бит | 256 | 2х256 | 512 | 448 | 2х256 | 2х256 | 256 |

| Интерфейс | PCI-E х16 v2.0 | PCI-E х16 v2.0 | PCI-E х16 v2.0 | PCI-E х16 v2.0 | PCI-E х16 v2.0 | PCI-E х16 v1.0 | PCI-E х16 v2.0 |

| Версия DirectX | 10 | 10 | 10 | 10 | 10.1 | 10.1 | 10.1 |

| Версия вершинных шейдеров | 4.0 | 4.0 | 4.0 | 4.0 | 4.1 | 4.1 | 4.1 |

| Версия пиксельных шейдеров | 4.0 | 4.0 | 4.0 | 4.0 | 4.1 | 4.1 | 4.1 |

| Разъемы | TV-Out2x DVI Dual Link HDTV | 2x DVI Dual Link, HDMI | TV-Out 2x DVI Dual Link HDTV | TV-Out 2x DVI Dual Link HDTV | TV-Out 2x DVI Dual Link HDTV | TV-Out 2x DVI Dual Link HDTV | TV-Out 2x DVI Dual Link HDTV |

| Ориентировочная стоимость* | $270 | $450 | $540 | $340 | $850 | $420 | $340 |

*На момент подготовки материала.

Итак, в верхнем ценовом диапазоне компании NVIDIA разместились четыре видеокарты со следующими рекомендованными стоимостями:

. NVIDIA GeForce GTX 280 — $499;

. NVIDIA GeForce GTX 280 — $299.

"Хм… что-то уж больно дешево для флагманской платы!"- подумаете вы, и будете правы. Изначально стоимость ускорителя GTX 280 составляла $649 (!), в то время как цена на GTX 260 должна была быть около $399. Но тут в дело вмешалась AMD, которая представила весьма конкурентоспособные и высокопроизводительные чипы линейки HD 48ХХ, на что NVIDIA, кроме как снижением цен, собственно говоря, ответить было нечем. Такое положение дел очень отрицательно отразилось на материальном положении калифорнийского брэнда, ведь "супертранзисторный" GT200 обходится компании довольно дорого, а тут еще и снижение цен… С другой стороны, такие обстоятельства весьма обрадуют покупателей, так как не лишним будет сэкономить $100- $150, а это более чем приятно! На этом с теорией, пожалуй, закончим — настало время перейти к практическим тестам, правда, перед этим нужно поближе познакомиться с сегодняшним гостем, чем мы, собственно говоря, сейчас и займемся.

Видеокарта Point Of View GeForce GTX 280 1024 MB

Комплектация, дизайн PCB и конструкция системы охлаждения

В целом по факту размещения характеристик и особенностей продукта на коробке нареканий нет, а вот дизайн оформления бокса — на любителя. Внутри коробки по отсекам уложен следующий комплект:

. руководство по быстрой установке;

. CD с драйверами и утилитами;

. переходник DVI-I на D-SUB;

. переходник DVI-I на HDMI;

. специальный переходник питания 2х Molex на 6-пиновый PCI Express;

. специальный переходник питания 2х 6-пиновый PCI Express -> 8-пиновый PCI Express;

. аудиокабель для передачи звука на разъем HDMI.

В плане дизайна PCB данная плата полностью идентична классической GeForce GTX 280.

Длина видеокарты GeForce GTX 280 составляет 270 мм, что полностью соответствует типичной NVIDIA GeForce 8800 GTX. Высота всей конструкции неизменна по всей длине и составляет 30 мм, поэтому на материнской плате ниже разъема PCE-16x не должно быть сильно выступающих элементов и разъемов, иначе карта просто физически не "встанет". Для дополнительной подпитки видеокарты используется один 6-контактный разъем и один 8- контактный.

Температурный режим, разгон, уровень энергопотребления исследуемых плат

Для мониторинга тепловых показателей ускорителя воспользуемся утилитой RivaTuner 2.11. Для большей наглядности все данные сведем в

соответствующую таблицу:

| Наименование видеокарты | Point Of View GeForce GTX 280 1024 MB |

| Условия тестирования | Закрытый стенд |

| Температура окружающего воздуха | 25,5°С |

| Температурные показатели, режим простоя (2D) | |

| Графический процессор, макс. значение | 50°C |

| Температурные показатели (3D) | |

| Графический процессор, макс. значение | 85°C |

| Температура внешних элементов видеокарты* | |

| Радиатор GPU | 58°С |

*Измерено с помощью цифрового термометра Mastech MS-6501.

поддерживалась на уровне 85°С, что не выходит за рамки допустимого.

Разгонные показатели Point Of View GeForce GTX 280 1024 MB:

| Подсистема | GPU | Память | Шейдерный домен |

| Номинальные частоты | 600 | 2200 | 1296 |

| Частоты, полученные разгоном | 678 | 2376 | 1458 |

| Прирост | 13% | 8% | 12,5% |

| Температурные показатели (3D) | |||

| Максимальная температура GPU | 79°C** | ||

| Радиатор GPU* | 55°C |

*Измерено с помощью цифрового градусника Mastech MS-6501.

** При частотах кулера 70% (принудительно установленные посредством утилиты RivaTuner).

Чем сложнее чип, чем больше транзисторов, тем труднее он поддается разгону и всевозможным манипуляциям с его частотами. Совершенно очевидно, что большого прироста (до 25%, как у G92) в плане разгона от GT200 ожидать и не приходится.

Конфигурация тестового стенда, список тестовых приложений и настроек

Конфигурация тестового стенда:

| Материнская плата | Gigabyte EX38-DQ6 (X38) |

| Процессор | Intel Core 2 Quad QX6700 2,66 ГГц, разогнанный до 3,2 ГГц (266x12) |

| Память | Chaintech APOGEE PC-6400 DDR II (2x2 Гб, CL4-4-4-12), 2,1 В |

| Винчестер | Системный: WD Raptor 74 GB WD740ADFD (10.000 об/мин, Serial ATA, буфер 16 Мб) Игры и программы: Seagate ST3500320AS 500 GB (Serial ATA II, буфер 32 Мб |

| Блок питания | Floston Energetix 850 Вт (ENFP-850W); |

| Монитор | Compaq P1210 (22", максимальное разрешение 2048х1536@75 Гц) |

| Операционная система (тесты DX10) | Microsoft Windows Vista Ultimate 64 bit SP1, DirectX 10 (сборка август 2008 г.) |

| Драйверы для видеокарт NVIDIA | GeForce 178.13 |

| Драйверы для видеокарт AMD | ATI Catalyst 8.9 |

В тестировании, помимо Point Of View GeForce GTX 280 1024 MB, также принимали участие:

. NVIDIA GeForce GTX 260;

. NVIDIA GeForce 9800 GTX;

. NVIDIA GeForce 9800 GX2;

. AMD Radeon HD 4870.

Во время тестирования использовались следующие настройки драйверов:

Для GeForce 178.13:

. texture filtering — high quality;

. vertical sync — off;

. anisotropic optimization — off;

. anisotropic sample optimization — off;

. transparency antialiasing — off.

Для AMD Catalyst 8.9:

. Catalyst A.I — standard;

. mipmap detail level — high quality;

. wait for vertical refresh — off;

. adaptive antialiasing — off;

. temporal antialiasing — off;

. high quality anisotropic filtering — off.

Все остальные настройки — по умолчанию.

| Приложение | Версия | API | Настройки качества | Антиалиасинг | Анизотропная фильтрация |

| 3DMark Vantage | 1.01 | DirectX 10 | Performance | - | - |

| Extreme | FSAA 4x | x16 | |||

| Devil May Cry 4 Benchmark | 1.00 | DirectX 10 | Max. Quality | FSAA 4x | x16 |

| Call Of Juarez Benchmark | 1.3.0.1 | DirectX 10 | Max. Quality | - | - |

| Call of Duty 4: Modern Warfare | 1.6 | DirectX 9 | Max. Quality | FSAA 4x | x16 |

| Company Of Heroes Opposing Fronts | 1.7.1 | DirectX 10 | Max. Quality | FSAA 4x | x16 |

| Crysis | 1.2.1 | DirectX 9.0c | High Quality | - | - |

| DirectX 10 | Very High Quality | - | - | ||

| Gothic 3 | 1.12 | DirectX 9.0c | Max. Quality | - | x16 |

| Ghost Recon Advanced Warfighter 2 | 1.0 | DirectX 9.0c | Max. Quality | FSAA 4x | x16 |

| PT Boats: Knights of the Sea DirectX 10 Benchmark | 1.00 | DirectX 10 | Max. Quality | FSAA 4x | x16 |

| S.T.A.L.K.E.R. | 1.005 | DirectX 9.0c | Max Quality, Dynamic Light On | - | x16 |

| Tomb Raider: Legend | 1.2 | DirectX 9.0c | Max. Quality, NGC ON. | FSAA 4x | x16 |

| World In Conflict | 1.007 | DirectX 10 | Maximum Quality | FSAA 4x | x16 |

| 3D Mark Vantage | |||

| Extreme | Perfomance | ||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 2995 | 9010 | |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 2117 | 5790 | |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 3125 | 9456 | |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 3835 | 8406 | |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 5029 | 12321 | |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 5530 | 13455 | |

| Devil May Cry 4 Benchmark | |||

| 1920x1080 | 1280x1024 | 1024x768 | |

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 75.3 | 96.6 | 127.5 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 55.3 | 71.8 | 90.5 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 92.3 | 115.2 | 159.3 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 60.7 | 80.5 | 105.5 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 83.2 | 109.2 | 147.5 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 90.2 | 120.2 | 160.3 |

| Call Of Juarez Benchmark | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 44.9 | 57.9 | 78.7 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 24.4 | 31.3 | 39.2 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 34.1 | 48.1 | 65.8 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 31.5 | 40.6 | 52.6 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 37.8 | 50.1 | 66.5 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 41.1 | 55.1 | 72.1 |

| Call of Duty 4: Modern Warfare | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 60.6 | 85.3 | 105.2 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 49.9 | 75.4 | 95.3 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 84.1 | 107.9 | 133.2 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 67.3 | 84.4 | 108.4 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 85.7 | 108.5 | 132.5 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 94.2 | 119.5 | 143.2 |

| Company Of Heroes Opposing Fronts | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 40.8 | 54.2 | 60.3 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 39.5 | 61.2 | 79.7 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 55.5 | 86.7 | 95 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 56.8 | 86.2 | 98.7 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 71.6 | 102.8 | 112.9 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 76.2 | 111.3 | 123.1 |

| Crysis DX9 | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 37.3 | 50.1 | 78.6 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 31.3 | 46.2 | 62.4 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 45.1 | 56.1 | 67.4 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 37.4 | 55.6 | 58.3 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 45.2 | 58 | 60.3 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 49.7 | 63.8 | 66.2 |

| Crysis DX10 | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 20.3 | 30.2 | 43 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 11.8 | 22.1 | 31.8 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 23.2 | 36.4 | 40.1 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 16.7 | 30.7 | 34.7 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 22.3 | 33.1 | 41.8 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 24.5 | 36.5 | 46 |

| Gothic 3 | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 48 | 64.4 | 70 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 51.1 | 69.2 | 84.3 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 63.8 | 77 | 85.1 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 51.4 | 66.7 | 72 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 60.7 | 74 | 78.3 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 66.5 | 80.2 | 86.1 |

| Ghost Recon Advanced Warfighter 2 | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 60.5 | 90.7 | 121.7 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 66.7 | 92.4 | 100.1 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 88.3 | 100.6 | 140.9 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 80.3 | 95.7 | 104.6 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 91.7 | 107.9 | 143.2 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 100 | 118.6 | 156.7 |

| PT Boats: Knights of the Sea DirectX 10 Benchmark | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 20.2 | 35.5 | 43.4 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 28.3 | 39.9 | 58.2 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 45.2 | 51.7 | 60.9 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 34.3 | 47 | 55.9 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 49.3 | 53.3 | 58.6 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 54.3 | 58.6 | 64.1 |

| S.T.A.L.K.E.R. | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 18.3 | 23.7 | 28.2 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 25.4 | 35.1 | 46.9 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 35.1 | 49.7 | 61.5 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 21.2 | 30.2 | 38.7 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 25.6 | 36.7 | 46.3 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 28.1 | 40 | 51.2 |

| Tomb Raider: Legend | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 61.1 | 89.3 | 124.6 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 55.1 | 83.3 | 121.2 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 90.1 | 132.4 | 186.5 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 77.9 | 113 | 158.7 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 73.3 | 96.6 | 190 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 80.1 | 106.3 | 195 |

| World In Conflict | |||

| AMD Radeon HD 4870 512 MB 750/3600 МГц | 29 | 3 | 37 |

| NVIDIA GeForce 9800 GTX 512 MB 675/2200 МГц | 39 | 46 | 50 |

| NVIDIA GeForce 9800 GX2 2х512 MB 600/2000 МГц | 40 | 42 | 46 |

| NVIDIA GeForce GTX 260 896 MB 576/2000 МГц | 30 | 37 | 41 |

| POV GeForce GTX 280 1024 MB 600/2200 МГц | 37 | 42 | 47 |

| POV GeForce GTX 280 1024 MB OC 680/2380 МГц | 42 | 47 | 51 |

Выводы

Несомненно, на данный момент GT200 является самым сложным и высокопроизводительным чипом на рынке. К сожалению, в архитектурном плане новоиспеченный чип не представляет ничего кардинально нового. В некоторых моментах NVIDIA действительно удалось значительно повысить эффективность архитектуры, а также существенно увеличить количество вычислительных блоков по отношению к прошлым чипам, в остальном же GT200 мало чем отличается от G92. Производительность GeForce GTX 280 ощутимо шагнула вперед по сравнению с одиночным G92 (GeForce 9800 GTX), но не стоит забывать, что на рынке присутствует также мощное мультичиповое решение GeForce 9800 GX2, которое по результатам наших тестов в основной массе бенчмарков обходит GTX 280. Правда, в этом случае стоит обязательно учитывать тот факт, что вычислительная мощь мультичиповых плат во многом зависит от драйверов и соответствующей оптимизации приложений под многоядерный рендеринг. Поэтому multi-GPU-видеокарта может показывать превосходную производительность только в популярных бенчмарках и играх, а в менее ходовых могут наблюдаться проблемы. Основная "болезнь" нынешнего флагманского чипа GT200 кроется в его высоком энергопотреблении и тепловыделении. Решить эту проблему (как один из вариантов) кардинальным образом можно лишь перейдя на более тонкий техпроцесс. Кроме того, это позволит значительно снизить себестоимость производства таких чипов.

Point Of View GeForce GTX 280 1024 MB

Дизайн платы полностью соответствует референсному GeForce GTX 280, посему выбор в пользу того или иного брэнда (из многообразия стандартных плат) практически полностью будет зависеть от бонусов, комплекта и цены.

Плюсы:

. высокая производительность в приложениях (для одиночного чипа);

. приемлемая эффективность и шум системы охлаждения (с учетом очень горячего нрава GT200).

Минусы:

. скудный комплект поставки;

. низкий разгонный потенциал.

Дмитрий Трамбицкий

Компьютерная газета. Статья была опубликована в номере 46 за 2008 год в рубрике hard