Sapphire Radeon HD3870 X2. Один GPU хорошо, а лучше ли два?

В начале этого года, а именно 28 января, компания AMD представила (цитируем) "первый в мире двухпроцессорный графический ускоритель Radeon HD 3870 X2, обладающий пиковой производительностью 1 Терафлоп (один триллион операций с плавающей запятой в секунду)". Звучит убедительно и достаточно впечатляюще, но давайте поподробнее разберем, что стоит за этой короткой, но эффектной фразой.

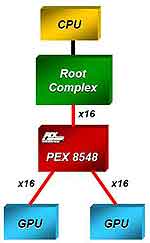

Итак, помещение двух чипов на одну плату — это факт скорее не инновационный, а эволюционный. ATI и ранее выпускала двухчиповые видеокарты, но ввиду несовершенства технологий и отсутствия эффективных алгоритмов совместного просчета 3D-сцены эти продукты не стали популярными. С переходом на шину PCI Express, более гибкую, чем PCI или AGP, появился сравнительно простой и надежный способ реализации связки CrossFire на одной печатной плате. Так, двухчиповая система, реализованная в рассматриваемом нами видеоадаптере, реализована при помощи коммутатора PCI Express на 48 линий, расположенного на плате видеоадаптера. С одной стороны он подключен к порту PCI Express материнской платы, с другой — к каждому из графических чипов по интерфейсу PCI Express x16, разведенному на плате видеоадаптера. Тем самым карта не требует поддержки CrossFire со стороны материнской платы и не использует дополнительных ресурсов. Оба графических процессора (GPU) снабжены своим массивом локальной видеопамяти. Отметим, что применение выделенной, а не совместно используемой памяти является потенциально узким местом данного решения, и ATI этот факт признает, рекомендуя специальные методы программирования, позволяющие избегать конфликтов между двумя графическими ядрами. Кроме того, на данном этапе драйверы не дают возможности изменить режим многопроцессорной обработки 3D-сцены, как в случае с "настоящей" конфигурацией CrossFire — двухпроцессорная видеокарта работает только в режиме AFR (Alternate Frame Rendering). Этот режим предполагает поочередное программирование каждого из GPU на прорисовку нового кадра. Пока центральный процессор занимается первым GPU, второй в это время занимается выполнением шейдеров, наложением текстур и другими действиями по формированию очередного кадра. Как только кадр будет готов, второй GPU будет готов к программированию, а первый в это время будет выполнять заданные действия. Если GPU выполняют свою работу слишком быстро, процессор может не справляться с поставками данных и синхронизацией содержимого двух массивов видеопамяти, и тогда двухпроцессорная видеокарта будет простаивать, что приведет к снижению производительности даже по сравнению с однопроцессорным вариантом. Поэтому наибольший прирост скорости следует ожидать, во-первых, на больших разрешениях, и во-вторых, в системах с мощным процессором.

Итак, помещение двух чипов на одну плату — это факт скорее не инновационный, а эволюционный. ATI и ранее выпускала двухчиповые видеокарты, но ввиду несовершенства технологий и отсутствия эффективных алгоритмов совместного просчета 3D-сцены эти продукты не стали популярными. С переходом на шину PCI Express, более гибкую, чем PCI или AGP, появился сравнительно простой и надежный способ реализации связки CrossFire на одной печатной плате. Так, двухчиповая система, реализованная в рассматриваемом нами видеоадаптере, реализована при помощи коммутатора PCI Express на 48 линий, расположенного на плате видеоадаптера. С одной стороны он подключен к порту PCI Express материнской платы, с другой — к каждому из графических чипов по интерфейсу PCI Express x16, разведенному на плате видеоадаптера. Тем самым карта не требует поддержки CrossFire со стороны материнской платы и не использует дополнительных ресурсов. Оба графических процессора (GPU) снабжены своим массивом локальной видеопамяти. Отметим, что применение выделенной, а не совместно используемой памяти является потенциально узким местом данного решения, и ATI этот факт признает, рекомендуя специальные методы программирования, позволяющие избегать конфликтов между двумя графическими ядрами. Кроме того, на данном этапе драйверы не дают возможности изменить режим многопроцессорной обработки 3D-сцены, как в случае с "настоящей" конфигурацией CrossFire — двухпроцессорная видеокарта работает только в режиме AFR (Alternate Frame Rendering). Этот режим предполагает поочередное программирование каждого из GPU на прорисовку нового кадра. Пока центральный процессор занимается первым GPU, второй в это время занимается выполнением шейдеров, наложением текстур и другими действиями по формированию очередного кадра. Как только кадр будет готов, второй GPU будет готов к программированию, а первый в это время будет выполнять заданные действия. Если GPU выполняют свою работу слишком быстро, процессор может не справляться с поставками данных и синхронизацией содержимого двух массивов видеопамяти, и тогда двухпроцессорная видеокарта будет простаивать, что приведет к снижению производительности даже по сравнению с однопроцессорным вариантом. Поэтому наибольший прирост скорости следует ожидать, во-первых, на больших разрешениях, и во-вторых, в системах с мощным процессором.

Теперь что касается высокой, по словам пресс-секретариата AMD, производительности (как обстоят дела на самом деле, мы выясним чуть позже). Достигается она при помощи связки из двух графических процессоров RV670 и двух массивов локальной видеопамяти стандарта GDDR3, по 512 Мб на каждого. Данный графический чип был представлен еще в прошлом году — на их базе строятся однопроцессорные ускорители Radeon HD 3870 и Radeon HD 3850, которые, по замыслу производителя, должны были пошатнуть позиции видеокарт NVIDIA GeForce 8800GT. Несмотря на то, что RV670, в отличие от G92, строится по более современному техпроцессу с нормами 55 нм и отличался от последнего поддержкой функций DirectX 10.1, упомянутым видеоадаптерам не удалось толком даже посоперничать с продуктами NVIDIA, и даже неоднократное снижение цен ни к чему не привело. В то время, да и, пожалуй, сейчас, в ценовом сегменте $170-$210 GeForce 8800GT — безальтернативный чемпион. Но разговор у нас сегодня не о нем. Разговор пойдет о том, что представляет собой новое флагманское решение компании AMD/ATI, построенное на базе двух графических чипов RV670, и с каким продуктом NVIDIA оно способно конкурировать. Для этих целей мы проведем тестирование модели HD3870 X2 1G GDDR3 PCI-E производства компании Sapphire — классического варианта Radeon HD 3870 X2.

Теперь что касается высокой, по словам пресс-секретариата AMD, производительности (как обстоят дела на самом деле, мы выясним чуть позже). Достигается она при помощи связки из двух графических процессоров RV670 и двух массивов локальной видеопамяти стандарта GDDR3, по 512 Мб на каждого. Данный графический чип был представлен еще в прошлом году — на их базе строятся однопроцессорные ускорители Radeon HD 3870 и Radeon HD 3850, которые, по замыслу производителя, должны были пошатнуть позиции видеокарт NVIDIA GeForce 8800GT. Несмотря на то, что RV670, в отличие от G92, строится по более современному техпроцессу с нормами 55 нм и отличался от последнего поддержкой функций DirectX 10.1, упомянутым видеоадаптерам не удалось толком даже посоперничать с продуктами NVIDIA, и даже неоднократное снижение цен ни к чему не привело. В то время, да и, пожалуй, сейчас, в ценовом сегменте $170-$210 GeForce 8800GT — безальтернативный чемпион. Но разговор у нас сегодня не о нем. Разговор пойдет о том, что представляет собой новое флагманское решение компании AMD/ATI, построенное на базе двух графических чипов RV670, и с каким продуктом NVIDIA оно способно конкурировать. Для этих целей мы проведем тестирование модели HD3870 X2 1G GDDR3 PCI-E производства компании Sapphire — классического варианта Radeon HD 3870 X2.

Дизайн

Первое, что сразу же бросается в глаза, — это крупные размеры (и вес) видеоадаптера: длина PCB составляет 270 мм — такая длинная плата была у GeForce 8800 GTX. Далее расположение элементов: на лицевой части видеоадаптера имеется два GPU и специальный коммутатор PEX 8548 компании PLX, микросхемы памяти частично расположены спереди, а частично — на тыльной части печатной платы, всего их имеется 16 штук, производитель — корейская компания Samsung Electronics. В правом верхнем углу видеоадаптера находятся два 6-контактных разъема для подвода дополнительного питания. Что касается возможности по выводу видеосигнала, то для этих целей референсный вариант (а рассматриваемая нами сегодня карта именно таковым и является) предусматривает наличие на боковой панели двух портов DVI-D и одного S-Video. Подключение к мониторам с аналоговым интерфейсом производится через специальные адаптеры-переходники DVI-to-D-Sub, поставляемые в комплекте с картой. Также поставляются и переходник DVI-to-HDMI для подключения монитора или телевизора с этим интерфейсом.

Первое, что сразу же бросается в глаза, — это крупные размеры (и вес) видеоадаптера: длина PCB составляет 270 мм — такая длинная плата была у GeForce 8800 GTX. Далее расположение элементов: на лицевой части видеоадаптера имеется два GPU и специальный коммутатор PEX 8548 компании PLX, микросхемы памяти частично расположены спереди, а частично — на тыльной части печатной платы, всего их имеется 16 штук, производитель — корейская компания Samsung Electronics. В правом верхнем углу видеоадаптера находятся два 6-контактных разъема для подвода дополнительного питания. Что касается возможности по выводу видеосигнала, то для этих целей референсный вариант (а рассматриваемая нами сегодня карта именно таковым и является) предусматривает наличие на боковой панели двух портов DVI-D и одного S-Video. Подключение к мониторам с аналоговым интерфейсом производится через специальные адаптеры-переходники DVI-to-D-Sub, поставляемые в комплекте с картой. Также поставляются и переходник DVI-to-HDMI для подключения монитора или телевизора с этим интерфейсом.

Далее устройство системы охлаждения. На видеоадаптере Sapphire Radeon HD3870 X2 установлен эталонный кулер типа "турбина". Вся конструкция (даже частично на задней части) накрыта красным полупрозрачным пластиком. Под ним скрываются либо две медные пластины радиатора (такая система характерна для новых ревизий Radeon HD3870 X2), либо одна медная и одна алюминиевая пластина (такую систему охлаждения можно встретить на Radeon HD3870 X2 первой волны). Во втором варианте пластина из алюминия устанавливается ближе к крупному вентилятору турбинного типа, расположенному в правом конце системы охлаждения. Дополнительное охлаждение микросхем памяти на лицевой стороне обеспечивается алюминиевым штырьковым радиатором, на тыльной — обыкновенной алюминиевой пластиной. В конце упомянем, что все металлические элементы кулера контактируют с охлаждаемыми поверхностями через термоскотч.

Тестирование

Мы достаточно долго думали над тем, какую видеокарту "выставить на ринг" против двухпроцессорного флагмана AMD, и решили, что оппонентом для тестирования станет мощный видеоакселератор NVIDIA GeForce 9800 GTX производства компании InnoVISION (полное название модели: Inno3D I-9800GTX- H5GTCDS). Видеоадаптер Inno3D представляет собой стандартное решение на базе GeForce 9800 GTX, оснащенное 512 Mb локальной видеопамяти стандарта GDDR3 с характерными для него частотами 675/1675/2200 MHz (графический чип, шейдерный блок, микросхемы памяти). Перед тем, как познакомить вас с результатами тестирования, приведем сравнительные характеристики обоих видеоадаптеров, а также напомним конфигурацию компьютера, используемого нами в качестве тестового стенда:

. процессор Intel Core 2 Duo E6300, разогнанный до 3,2 GHz;

. материнская плата ASUS P5B (чипсет Intel P965);

. память A-Data PC-6400 2x1 Gb;

. жесткий диск Samsung SP1213N.

Набор игровых приложений следующий: Company of Heroes, S.T.A.L.K.E.R, Crysis, World In Conflict, Call of Duty 4, Enemy Territory и Unreal Tournament 3 для DirectX9; Crysis, World In Conflict и Unreal Tournament 3 для DirectX10. Как и полагается для мощных видеоадаптеров, тестировать их будем при разрешениях экрана 1280х1024 и 1680х1050 пикселей при двух различных настройках видеодрайвера: "максимальная производительность" (принудительно отключены антиальясинг и анизотропная фильтрация) и "максимальное качество" (режим антиальясинга AA4х, анизотропной фильтрации — AF16х). Производительность в играх для DirectX9 измерялась в операционной системе Windows XP с установленным набором заплаток Service Pack 2. Для видеоадаптера Sapphire Radeon HD3870 X2 1G GDDR3 использовались драйверы ATI Catalyst версии 8.5, для Inno3D I- 9800GTX-H5GTCDS — NVIDIA ForceWare 174.74. Напомним: режим CrossFire выбрать нельзя — по умолчанию включен AFR.

В обоих режимах работы под управлением DirectX9 видеоадаптер Sapphire Radeon HD3870 X2 1G GDDR3 показывает схожие с Inno3D I-9800GTX-H5GTCDS результаты, причем в большинстве случаев хоть и не намного, но уступая последнему. Ощутимо выигрывает видеоадаптер AMD лишь в Company of Heroes и S.T.A.L.K.E.R. С чем это связано? Ответы достаточно просты. Во-первых, большинство DirectX9-приложений оптимизировано для работы с одним графическим процессором: возможные конфликты между двумя GPU способны существенно снизить производительность. Кроме того, у нас возникли серьезные сомнения относительно корректности работы драйверов Catalyst для Windows XP — подтверждением тому можно считать результаты работы адаптера в том же Crysis, но под Windows Vista. Кроме этого, ознакомившись с многочисленными форумами на эту тему, а также несколькими тестовыми обзорами, проведенными нашими заграничными и отечественными коллегами, мы пришли к выводу, что данная проблема имеет место быть.

Выводы

Видеоадаптеры серии Radeon HD3870 X2 бесспорно обладают высоким потенциалом в плане производительности. Однако на данный момент полноценно раскрыться ему мешают два нюанса: во-первых, недоработки в драйверах ATI Catalyst, во-вторых, малое количество игровых приложений, оптимизированных для работы с системой ATI Crossfire X. Все, что сможем сделать мы с вами, дорогие наши читатели, — это лишь пожелать компании ATI больше уделять внимания разработке и оптимизации драйверов, а разработчикам игр — обратить внимание на новые тенденции в производстве видеоадаптеров, а именно на двух- (возможно, в ближайшем времени и более) процессорные решения, которые видятся производителям наиболее простыми и действенными способами наращивания производительности. Что касается конкретно видеоадаптера Sapphire Radeon HD3870 X2 1G GDDR3, то краткое резюме будет следующим: стандартная референсная видеокарта, не вызывающая никаких, кроме относящихся ко всем Radeon HD3870 X2, нареканий. Из плюсов, помимо, опять же, тех, что присущи всем двухпроцессорным решениям AMD, можно выделить внушительный комплект поставки, а также относительно невысокую для данного класса устройств цену.

Плюсы:

. наиболее доступный двухпроцессорный ускоритель;

. богатый комплект поставки;

. высокий потенциал.

Минусы:

. крупные габариты видеокарты;

. проблемы с драйверами (надеемся, временные).

Андрей Бородин

| Название | Radeon HD 3870X2 1 GB | GeForce 9800 GTX 512M |

| Производитель | Sapphire | Inno3D (Innovision) |

| Модель | HD3870 X2 1G GDDR3 PCI-E | I-9800GTX-H5GTCDS |

| 3D-ускоритель | 2 х RV670 (2 x 320 sp) | G92 rev. A2 |

| - транзисторов | 2 х 666 млн | 754 млн |

| - техпроцесс | 55 нм | 65 нм |

| - базовая частота | 825 МГц | 675 МГц |

| - частота шейд. процессоров | 1675 МГц | |

| - кол-во шейд. процессоров | 320 | 128 |

| - кол-во TMU | 16 | 64 |

| - кол-во ROP | 16 | 16 |

| Память | GDDR3 | GDDR3 |

| - объем | 2 x 512 Мб | 512 Мб |

| - частота | 900 (1800) МГц | 1100 (2200) МГц |

| - шина | 2 х 256 бит | 256 бит |

| Охлаждение | активное | активное |

| Интерфейс | PCI Express 1.1 x16 | PCI Express 2.0 x16 |

| Выходы | ||

| - DVI | 2 | 2 |

| - VGA (D-Sub) | - | - |

| - TV-out | 1 | 1 |

| - TV-in | - | - |

| - HDMI | - | - |

| - DisplayPort | - | - |

| Средняя розничная цена | $500 | $400 |

Дизайн

Далее устройство системы охлаждения. На видеоадаптере Sapphire Radeon HD3870 X2 установлен эталонный кулер типа "турбина". Вся конструкция (даже частично на задней части) накрыта красным полупрозрачным пластиком. Под ним скрываются либо две медные пластины радиатора (такая система характерна для новых ревизий Radeon HD3870 X2), либо одна медная и одна алюминиевая пластина (такую систему охлаждения можно встретить на Radeon HD3870 X2 первой волны). Во втором варианте пластина из алюминия устанавливается ближе к крупному вентилятору турбинного типа, расположенному в правом конце системы охлаждения. Дополнительное охлаждение микросхем памяти на лицевой стороне обеспечивается алюминиевым штырьковым радиатором, на тыльной — обыкновенной алюминиевой пластиной. В конце упомянем, что все металлические элементы кулера контактируют с охлаждаемыми поверхностями через термоскотч.

Тестирование

Мы достаточно долго думали над тем, какую видеокарту "выставить на ринг" против двухпроцессорного флагмана AMD, и решили, что оппонентом для тестирования станет мощный видеоакселератор NVIDIA GeForce 9800 GTX производства компании InnoVISION (полное название модели: Inno3D I-9800GTX- H5GTCDS). Видеоадаптер Inno3D представляет собой стандартное решение на базе GeForce 9800 GTX, оснащенное 512 Mb локальной видеопамяти стандарта GDDR3 с характерными для него частотами 675/1675/2200 MHz (графический чип, шейдерный блок, микросхемы памяти). Перед тем, как познакомить вас с результатами тестирования, приведем сравнительные характеристики обоих видеоадаптеров, а также напомним конфигурацию компьютера, используемого нами в качестве тестового стенда:

. процессор Intel Core 2 Duo E6300, разогнанный до 3,2 GHz;

. материнская плата ASUS P5B (чипсет Intel P965);

. память A-Data PC-6400 2x1 Gb;

. жесткий диск Samsung SP1213N.

Набор игровых приложений следующий: Company of Heroes, S.T.A.L.K.E.R, Crysis, World In Conflict, Call of Duty 4, Enemy Territory и Unreal Tournament 3 для DirectX9; Crysis, World In Conflict и Unreal Tournament 3 для DirectX10. Как и полагается для мощных видеоадаптеров, тестировать их будем при разрешениях экрана 1280х1024 и 1680х1050 пикселей при двух различных настройках видеодрайвера: "максимальная производительность" (принудительно отключены антиальясинг и анизотропная фильтрация) и "максимальное качество" (режим антиальясинга AA4х, анизотропной фильтрации — AF16х). Производительность в играх для DirectX9 измерялась в операционной системе Windows XP с установленным набором заплаток Service Pack 2. Для видеоадаптера Sapphire Radeon HD3870 X2 1G GDDR3 использовались драйверы ATI Catalyst версии 8.5, для Inno3D I- 9800GTX-H5GTCDS — NVIDIA ForceWare 174.74. Напомним: режим CrossFire выбрать нельзя — по умолчанию включен AFR.

| 1280x1024, AA/AF off | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Company of Heroes | 179.5 | 171 |

| S.T.A.L.K.E.R. | 156.4 | 145.6 |

| Crysis | 44.8 | 46.9 |

| World In Conflict | 43 | 45 |

| Call of Duty 4 | 108.3 | 109.4 |

| Enemy Territory | 49.2 | 62.3 |

| Unreal Tournament 3 | 80.9 | 80.2 |

| 1680x1050, AA/AF off | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Company of Heroes | 148.9 | 141.8 |

| S.T.A.L.K.E.R. | 143.4 | 122.9 |

| Crysis | 36.8 | 41.8 |

| World In Conflict | 40 | 45 |

| Call of Duty 4 | 103.1 | 105.6 |

| Enemy Territory | 49.2 | 61.5 |

| Unreal Tournament 3 | 80.1 | 78.2 |

| 1280x1024, AA 4x, AF 16x | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Company of Heroes | 139.1 | 135.8 |

| S.T.A.L.K.E.R. | ||

| Crysis | 23.6 | 28.3 |

| World In Conflict | 40 | 38 |

| Call of Duty 4 | 69.9 | 71.3 |

| Enemy Territory | 45.8 | 58.7 |

| Unreal Tournament 3 | 60.1 | 57.2 |

| 1680x1050, AA 4x, AF 16x | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Company of Heroes | 106.3 | 99.4 |

| S.T.A.L.K.E.R. | ||

| Crysis | 18.6 | 21.6 |

| World In Conflict | 36 | 35 |

| Call of Duty 4 | 59.9 | 62.3 |

| Enemy Territory | 43.6 | 50.3 |

| Unreal Tournament 3 | 52.2 | 51.6 |

В обоих режимах работы под управлением DirectX9 видеоадаптер Sapphire Radeon HD3870 X2 1G GDDR3 показывает схожие с Inno3D I-9800GTX-H5GTCDS результаты, причем в большинстве случаев хоть и не намного, но уступая последнему. Ощутимо выигрывает видеоадаптер AMD лишь в Company of Heroes и S.T.A.L.K.E.R. С чем это связано? Ответы достаточно просты. Во-первых, большинство DirectX9-приложений оптимизировано для работы с одним графическим процессором: возможные конфликты между двумя GPU способны существенно снизить производительность. Кроме того, у нас возникли серьезные сомнения относительно корректности работы драйверов Catalyst для Windows XP — подтверждением тому можно считать результаты работы адаптера в том же Crysis, но под Windows Vista. Кроме этого, ознакомившись с многочисленными форумами на эту тему, а также несколькими тестовыми обзорами, проведенными нашими заграничными и отечественными коллегами, мы пришли к выводу, что данная проблема имеет место быть.

| 1280x1024, AA/AF off | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Unreal Tournament 3 | 57.5 | 56.9 |

| World In Conflict | 36 | 39 |

| Crysis | 19.6 | 23.4 |

| 1680x1050, AA/AF off | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Unreal Tournament 3 | 57.9 | 57.1 |

| World In Conflict | 34 | 38 |

| Crysis | 15.5 | 16.6 |

| 1280x1024, AA 4x, AF 16x | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Unreal Tournament 3 | 56.7 | 53.6 |

| World In Conflict | 30 | 29 |

| Crysis | 16.9 | 14.6 |

| 1680x1050, AA 4x, AF 16x | Sapphire 3870x2 1GB | Inno3D 9800GTX 512M |

| Unreal Tournament 3 | 53.9 | 52.1 |

| World In Conflict | 27 | 26 |

| Crysis | 11.8 | 7.9 |

Выводы

Видеоадаптеры серии Radeon HD3870 X2 бесспорно обладают высоким потенциалом в плане производительности. Однако на данный момент полноценно раскрыться ему мешают два нюанса: во-первых, недоработки в драйверах ATI Catalyst, во-вторых, малое количество игровых приложений, оптимизированных для работы с системой ATI Crossfire X. Все, что сможем сделать мы с вами, дорогие наши читатели, — это лишь пожелать компании ATI больше уделять внимания разработке и оптимизации драйверов, а разработчикам игр — обратить внимание на новые тенденции в производстве видеоадаптеров, а именно на двух- (возможно, в ближайшем времени и более) процессорные решения, которые видятся производителям наиболее простыми и действенными способами наращивания производительности. Что касается конкретно видеоадаптера Sapphire Radeon HD3870 X2 1G GDDR3, то краткое резюме будет следующим: стандартная референсная видеокарта, не вызывающая никаких, кроме относящихся ко всем Radeon HD3870 X2, нареканий. Из плюсов, помимо, опять же, тех, что присущи всем двухпроцессорным решениям AMD, можно выделить внушительный комплект поставки, а также относительно невысокую для данного класса устройств цену.

Плюсы:

. наиболее доступный двухпроцессорный ускоритель;

. богатый комплект поставки;

. высокий потенциал.

Минусы:

. крупные габариты видеокарты;

. проблемы с драйверами (надеемся, временные).

Андрей Бородин

Компьютерная газета. Статья была опубликована в номере 29 за 2008 год в рубрике hard